Vergangenes Jahr fragte sich die Bundeswehr auf Youtube, ob sogenannte Künstliche Intelligenz die „Waffe der Zukunft“ sei. KI ist vor allem ein Hype-Begriff für Anwendungen, die man noch vor wenigen Jahren für unwahrscheinlich hielt. Aktuell bekommen Text-, Bild- und Audio-Generatoren das Label „KI“ – oder Software, die mit hoher Wahrscheinlichkeit Objekte oder Gesichter wiedererkennt.

Im Youtube-Video der Bundeswehr sagt Michael Volkmer, Kommandeur des Zentrums Digitalisierung, mit Blick auf KI: „So richtig beschäftigen wir uns damit erst seit gut zwei Jahren“. Worin genau diese Beschäftigung besteht, wollte Mitte 2023 etwa die Bundestagsabgeordnete Anke Domscheit-Berg aus der Linksfraktion wissen, zunächst mit Blick auf die gesamte Bundesregierung.

Die Antwort auf ihre Kleine Anfrage war jedoch gerade in Bezug aufs Militär dünn: Welche KI-Anwendungen im Geschäftsbereich des Verteidigungsministeriums genutzt werden, wollte die Bundesregierung teils gar nicht offenlegen, teils nur unter Ausschluss der Öffentlichkeit. Die Abgeordnete kritisierte das Militär als „besonders finstere Blackbox“.

Zumindest inzwischen nennt die Bundeswehr im Netz eine Reihe von Anwendungen, die sie erprobt oder einsetzt, und die gemeinhin als KI bezeichnet werden. Dazu gehören verschiedene Anwendungen mit Sprachmodellen, also eine Technologie, die durch ChatGPT berühmt wurde, oder Bild-Erkennung gegen Desinformation. Eine wichtige Rolle spielt dabei die BWI GmbH, nach eigenen Angaben das „IT-Systemhaus der Bundeswehr“.

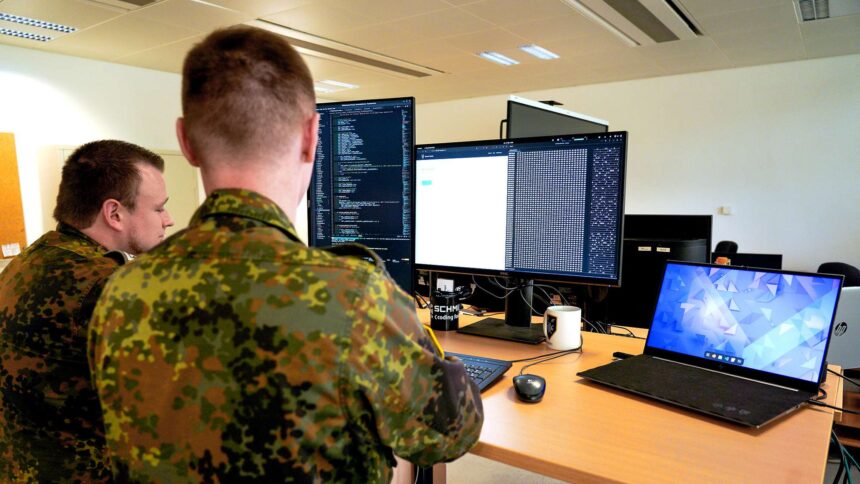

In Folge einer Presseanfrage zu KI bei der Bundeswehr erhielt netzpolitik.org eine Einladung ins KI-Labor beim sogenannten Bataillon für elektronische Kampfführung 912 in Niedersachsen. Die Reise geht also nach Nienburg/Weser, knapp eine Stunde von Hannover entfernt. Laut den Verantwortlichen seien dort seit 2018 testweise Soldaten im Labor aktiv, 2020 folgte dann die offizielle Eröffnung.

Aus Gründen der Sicherheit wolle die Pressestelle jedoch nicht offenlegen, wie viele Soldat:innen dort aktiv seien. Zumindest in einem Interview mit dem verantwortlichen Truppenführer Yannick Z. aus dem Jahr 2022 war die Rede von elf Soldat:innen. Diese Zahl wollte die Pressestelle weder bestätigen noch verneinen. Sie hätte sich allerdings auch nicht grundlegend verändert. Um ein sehr großes KI-Labor kann es sich also nicht handeln, gerade im Vergleich zum militärischen Personal von 13.800 Menschen, die laut Bundeswehr insgesamt im Bereich „Cyber- und Informationsraum“ arbeiten.

Mit KI fürs Militär Millionen verdienen

Bei unserem Besuch zeigt sich Nienburg/Weser umgeben von nebelverhangenen Feldern. Aus der Ferne sind Schüsse zu hören. Zur Begrüßung wartet die Bundeswehr mit mehreren uniformierten Personen auf: vier Pressemenschen und ein an KI-Themen interessierter Fregattenkapitän der Marine. Wenig später kommt der Kommandeur des Bataillons, Oberstleutnant Stefan Oehler, hinzu.

Beim KI-Labor gehe es um Dinge wie Flexibilität und Unabhängigkeit, wie die Bundeswehr-Vertreter erklären. Verbindungen zur freien Wirtschaft gebe es aber auch. So sehe sich der „Cyber Innovation Hub“ der Bundeswehr als „Brücke zwischen Bundeswehr und Start-up-Ökosystem“.

Ein Beispiel für die Verbindungen zwischen Industrie und Militär ist der Mitgründer und CEO des Anbieters für militärische KI-Anwendungen „Helsing“, Gundbert Scherf. Auf seiner Vita stehen die Beratungsfirma McKinsey, das Verteidigungsministerium – und die Gründung von Helsing. Das Unternehmen erhielt etwa 100 Millionen Euro von Spotify-Gründer Daniel Ek und Rüstungsaufträge vom Verteidigungsministerium. Die Wirtschaftswoche nannte Helsing einen führenden Anbieter für KI in der Rüstung.

Manche Soldat:innen finden die Privatwirtschaft offenbar ebenso attraktiv und gründen nach ihrer Laufzeit Militär-Start-ups. Zu nennen wäre hier etwa die Münchner Firma „Arx Robotics“, die von drei ehemaligen Offizieren gegründet wurde und selbstfahrende Fahrzeuge entwickelt.

Auf den kurzen Weg von der Bundeswehr in die Wirtschaft angesprochen, beschreibt Oehler zwei Optionen, die Soldat:innen nach ihrer herkömmlichen Laufbahn haben: Entweder man verpflichte sich weiterhin im Bund oder man gehe in die Privatwirtschaft. Letzteres sei verlockend, aber Oehler appelliere an die „Ehre“ der Soldat:innen, sich nicht für den persönlichen Reichtum einzusetzen.

„Leichte Verstöße gegen das Völkerrecht“

Forschende wie Thomas Reinhold, der am Leibniz-Institut für Friedens- und Konfliktforschung in Frankfurt am Main zur Militarisierung des „Cyberspace“ und „KI“ arbeitet, sehen den Einsatz von KI-Anwendungen beim Militär kritisch. Die Kritik dreht sich um die Auslagerung der Verantwortung und die potenziell beschleunigte Kriegsführung.

Beim Besuch im KI-Labor betonen die Soldat.innen: Befehle könnten und sollten im Zweifel auch hinterfragt werden. Zwar müssen Soldat:innen laut Soldatengesetz Befehle „vollständig, gewissenhaft und unverzüglich“ ausführen. Dort steht aber auch: „Ungehorsam liegt nicht vor, wenn ein Befehl nicht befolgt wird, der die Menschenwürde verletzt.“

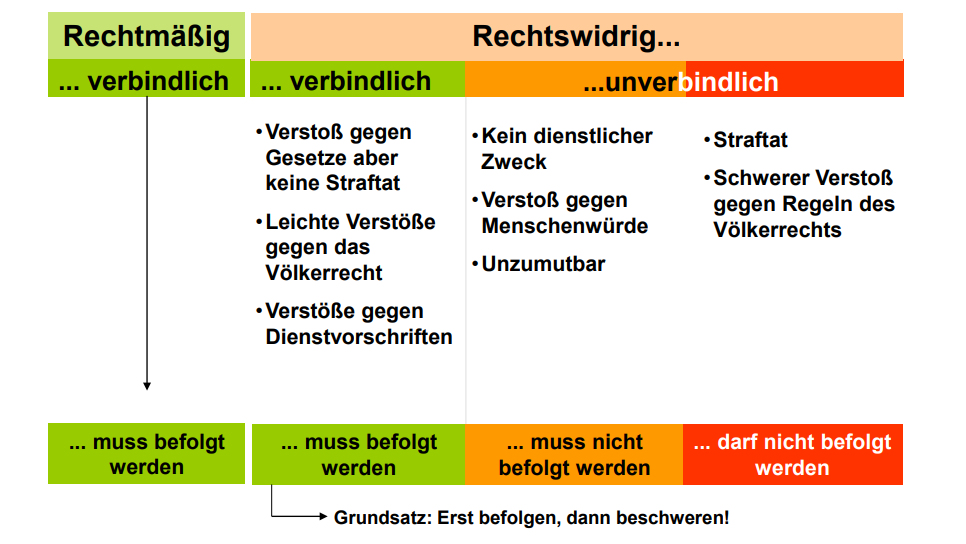

Zur Veranschaulichung lässt ein Presseoffizier der Redaktion aktuelles Lehrmaterial über „Befehl und Gehorsam“ aus der Grundausbildung zukommen. Beachtlich ist die Passage, wonach „leichte Verstöße gegen das Völkerrecht“ befolgt werden müssen. Darunter steht der Grundsatz „Erst befolgen, dann beschweren“.

Etwa hier setzt inhaltlich die Kritik an militärischen KI-Anwendungen an. Sie würden schnellere Entscheidungen ermöglichen und somit „für eine Beschleunigung der Kriegsführung“ sorgen, wie Konfliktforscher Thomas Reinhold argumentiert. Reflexionsprozesse könnten bei der Geschwindigkeiten zu kurz kommen: „Da wird man möglicherweise Opfer der eigenen Technologie“.

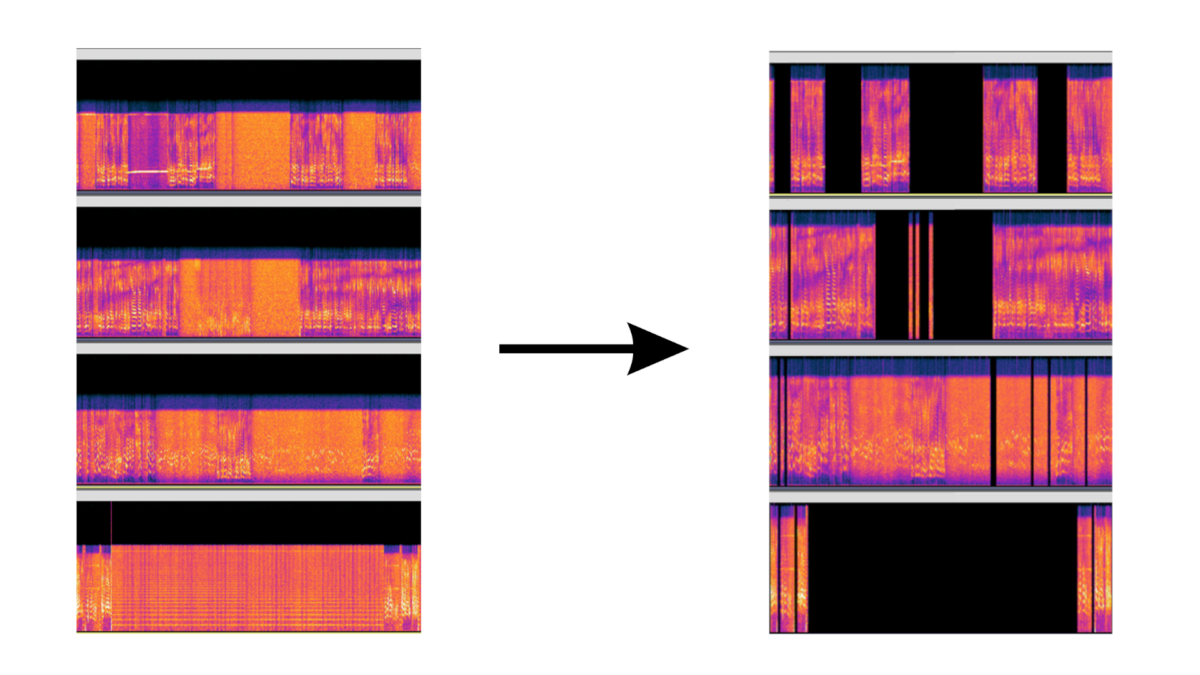

Anwendung entfernt Störgeräusche

Im KI-Labor präsentiert die Bundeswehr der Presse jedoch eher unauffällige Technologien. Das Labor ist ein einstöckiges Flachdach-Haus mit mehreren Räumen, die an den IT-Unterricht in der Schule erinnern. In einem dieser Räume zeigt Hauptfeldwebel Tobias R. eine Anwendung, die automatisiert Störgeräusche aus dem Funkverkehr herausfiltern soll: Der „Voice-Activity-Detector“. Auf diese Weise lassen sich in kurzer Zeit relevante Passagen mit gesprochenen Worten finden.

Für die Entwicklung selbst hätten Tobias R. und sein Team nur wenige Wochen benötigt; die Akkreditierung für den Einsatz habe dann allerdings zwei Jahre gedauert. Offenbar ein vergleichsweise kurzer Zeitraum, wie Tobias R. einordnet. Seit 2022 sei das System im Einsatz. Der Hauptfeldwebel nennt seine Entwicklung „ein Produkt aus der Truppe für die Truppe“.

Sein Alltag im KI-Labor bestehe aus Recherche und Experimentieren, wie Tobias R. erklärt. Aber auch Schießen, Marschieren und in Einsätze gehörten zum Alltag – „da kommen wir nicht drumherum“.

Was sagt der KI-begeisterte Hauptfeldwebel zu autonomen Waffensystemen? „Ich würde niemals so weit gehen, für ein System zu sorgen, das automatisiert Menschen tötet“, erklärt Tobias R., „das hat für mich einfach keinen ethischen Wert.“ Was mit seinen Entwicklungen allerdings später passiert, darüber werde er nicht informiert. „Wenn in 20 Jahren jemand auf die Idee kommt, das zweckzuentfremden, dann kann ich mich auch nicht mehr dagegen wehren“.

Normalisierung von autonomen Waffensystemen

Tobias R.s Vorgesetzte im Raum unterstreichen mit Blick auf den Einsatz von KI die Wichtigkeit des „Human in the Loop“. So nennt man den Grundsatz, dass immer noch ein Mensch die Entscheidungen treffen müsste. Ausgeblendet wird dabei oft, dass es in diesem Fall eine Software ist, die oft innerhalb kurzer Zeit vorgibt, worüber es überhaupt zu entscheiden gilt. Als „Automation bias“ bezeichnet man es, wenn Menschen dem Vorschlag einer Maschine vertrauen, einfach weil er von der Maschine kommt.

Konfliktforscher Thomas Reinhold kritisiert die zunehmende Normalisierung von autonomen Waffensystemen: „Diese Perspektive, dass der Mensch oft als Hindernis in der Entscheidungsfindung wahrgenommen wird, sieht man bereits.“ Die Bundeswehr sei zudem der „tragischen Logik des Militärs“ unterworfen: „In dem Moment, wo die einen Kräfte etablieren, steht man selbst unter Druck, solche Kräfte aufzubauen, um Schritt halten zu können“. Mit Blick auf die globalen militärischen Mächte, würde man sehen, dass KI ein „großer Aufrüstungstreiber“ sei.

Autonome Systeme sind kaum wegzudenken, obwohl sie kaum so weit implementiert sind.

Denke an FPV-Killerdrohnen. Diese müssen KI gegen Fahrzeuge beinhalten, um den Zielanflug trotz EW-Maßnahmen zu vollenden. Die sind selbst damit so billig, dass so einige Goldrandsysteme (in bestimmten Szenarien) konkret in Frage stehen.

Die Ukraine würde sich bei einem KI-Bann am Kopf kratzen müssen. Nun sind die meißten Systeme noch so, dass Menschen den Befehl und z.T. Anflug durchführen. Mit autonomer Loiteringmunition wird die „Erkennung legetimer Ziele“ sicherlich bald aufweichen, wie bei Minenfeldern. Dort sind Kapabilität und Batteriekapazität allerdings (noch) nicht unendlich hoch. Andere denkbare Systeme, wie eine autonome Gleitbombenabwurfplattform, bekommen koordinaten und Route auch eher vorgegeben, während Antiflugzeugdrohnen mit Loiteringfähigkeit sicherlich noch weit ausgebaut werden, u.a. um Gleitbombenabwerfer zu erwischen, das sicherlich dann auch autonom. In einem Kriegsgebiet wie der Ukraine hält sich der ethische Impact da wohl in Grenzen (gegenüber dem genozidalen menschlichen Ansatz). Die Kapabilitäten von Drohnenschwärmen allerdings, verschieben die Grenzen da sicherlich bald (/schon).

Hier ist allerdings nicht Entscheidungsgeschwindigkeit, sondern elektronische Kriegsführung der Treiber der Entwicklung.

Fliegende Maschinengewehrplattformen gibt es bereits. Der Zug ist mehr als halb abgefahren, die Bedrohungslage muss u.a. anhand des Ukrainekrieges neu bewertet werden. Das betrifft übrigens auch Anschlagsszenarien. Taktische ABC-Sprengköpfe ohne (sicheren) Aktivierungscode besorgen, Testen und einschmuggeln, oder KI-Mesh-Splitterdrohnen mit Crowderkennungs- und Suchfunktion, Standardteile, Software aus dem Internet? Kosten-Nutzen…